Con esta herramienta deepfake solo debes escribir lo que quieras que diga alguien

Una impresionante prueba de esta tecnología realizada por un grupo de investigadores muestra alcances que parecían impensados.

La tecnología de los deepfakes nos sigue sorprendiendo día a día, desde su rol más criticable en la difusión de noticias falsas hasta notables trabajos en museos; ahora esta técnica de Inteligencia Artificial (IA) abre un nuevo mundo de posibilidades gracias a lo demostrado por la impresionante prueba de un grupo de investigadores.

Según recoge The Verge, un grupo de científicos de la Universidad de Stanford, el Instituto Max Planck de Informática, la Universidad de Princeton y Adobe Research crearon una herramienta que básicamente permite escribir un texto y generar un video de una persona real diciendo esas palabras exactas. Todo aunque aquella persona nunca haya pronunciado parte de esa frase.

Los investigadores presentaron esta herramienta mediante un artículo titulado "Edición basada en texto de un video de cabeza parlante", donde exponen que los métodos usados para crear estos registros fueron basados "en transcripciones para producir un video realista en el que se haya modificado el diálogo del orador". Y aunque todo eso parece bastante complicado, no sería tan difícil.

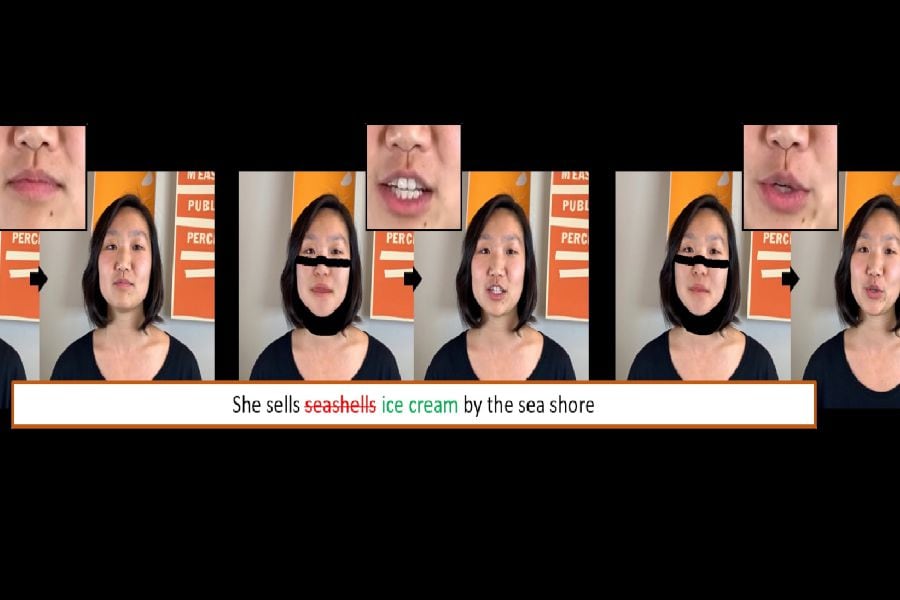

Para crear estos videos falsos los científicos emplearon varias técnicas, comenzado por escanear el video original para aislar los fonemas hablados por el sujeto. Es decir, los sonidos que constituyen su forma de hablar.

Posteriormente, dichos fonemas se vinculan con los visemas correspondientes, que son las expresiones faciales que acompañan a cada sonido. Finalmente, se crea un modelo 3D de la mitad inferior de la cara del sujeto utilizando el video de origen. Y listo, una persona diciendo la frase "Me encanta el olor del napalm por la mañana" de Apocalypse Now ahora puede decir "Me encanta el olor de las tostadas francesas por la mañana", sin siquiera pronunciar algunas de esas palabras.

https://youtu.be/0ybLCfVeFL4

Los videos generados por esta herramienta fueron mostrados a un grupo de 138 personas. De ese grupo, un 59.6% confundió los videos falsos con reales. Sin embargo, solo un 80.6% de los participantes consideró reales a los videos que efectivamente lo eran. Un factor que los científicos atribuyen a que los participantes estaban conscientes de que el estudio era sobre videos falsos.

Como pudieron ver en el video anterior, esta tecnología todavía esta en una etapa de desarrollo que tiene varios pasos por superar. Por ejemplo, aún no funcionaría bien cambiando discursos completos y solo se aplicaría a videos "de cabeza", es decir, a planos más cerrados y frontales. Sin embargo, eso no deja de poner sobre la mesa una serie de dudas éticas respecto a su uso.

Considerando que la herramienta aún no está disponible para todos los usuarios, en su artículo los investigadores plantean que, si bien podría usarse para fines como mejores herramientas de edición para la post-producción de películas, también podría tener usos peligrosos.

"Si bien los métodos para la manipulación de imágenes y videos son tan antiguos como los medios en sí mismos, los riesgos de abuso aumentan cuando se aplican a un modo de comunicación que a veces se considera evidencia autorizada de pensamientos e intenciones", acotan los responsables de la investigación. "Reconocemos que los malos actores pueden usar tales tecnologías para falsificar declaraciones personales y calumniar a personas prominentes".

Comenta

Por favor, inicia sesión en La Tercera para acceder a los comentarios.